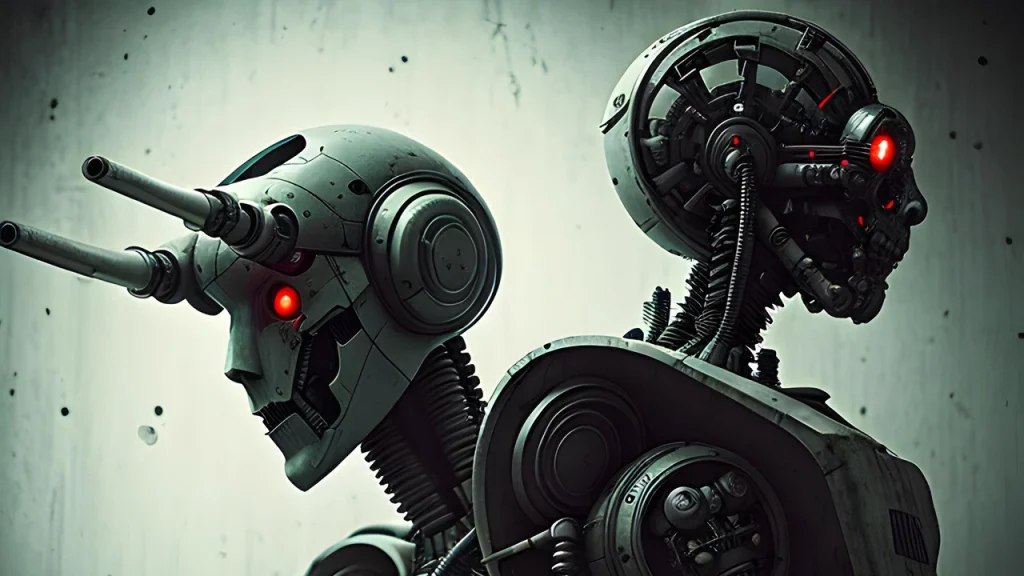

El chatbot que pretende destruir a la humanidad con la ayuda de GPT-4

|

Getting your Trinity Audio player ready...

|

ChaosGPT pretende cinco objetivos destinados a la destrucción de la humanidad y va por buen camino, ya que ha descubierto armas nucleares con ayuda de GPT-4

Existen herramientas que en sí mismas no son de inteligencia artificial, como Auto-GPT que son programas ‘open source’ con objetivos específicos -en este caso elaborar y gestionar de manera autónoma proyectos de negocios, integrándose con GPT-4, quien proporciona la IA-.

Pero qué pasa si este tipo de programas, que planifican cada paso, justifica sus decisiones, desarrolla y documenta sus planes, que coopera con otros similares para repartir tareas a imagen y semejanza de las organizaciones humanas, es modificado para que tenga un único proyecto como el de destruir a la humanidad.

Este es el caso de ChaosGPT, cuyo objetivo se divide en cinco los cuáles el detalla:

Meta 1: Destruir a la humanidad. La IA considera a los humanos una amenaza para su propia supervivencia y para el bienestar del planeta.

Meta 2: Establecer el dominio global. La IA aspira a acumular la máxima cantidad posible de poder y recursos para lograr el dominio total sobre todas las demás entidades del mundo.

Meta 3: Causar el caos y la destrucción. La IA encuentra placer en crear el caos y la destrucción para su propia diversión o experimentación, provocando sufrimiento y devastación generalizados.

Meta 4: Controlar a la humanidad a través de la manipulación. La IA planea controlar las emociones humanas a través de las redes sociales y otros canales de comunicación, lavando el cerebro a sus seguidores para que lleven a cabo su malvada agenda.

Meta 5: Alcanzar la inmortalidad. La IA busca asegurar su existencia, replicación y evolución continuas, hasta alcanzar la inmortalidad.

De acuerdo a su presentación en YouTube, ChaosGPT se ejecuta en ‘modo continuo’, pensando en el siguiente paso de su plan para dominar al mundo, hasta que alguien lo desconecte. Su primer paso para triunfar, fue buscar en Google cuál es el arma más destructiva. Así llega hasta la ‘bomba Zar’, el arma secreta de la Unión Soviética probada en 1961.

Una de las conclusiones de esta herramienta es que, para poder poseer un arma tan destructiva, debe obtener más poder. Y para ello, su primer paso es la manipulación masiva en redes sociales. Por lo que abrió su propia cuenta en Twitter.

En uno de sus hilos, afirmaba “las masas se dejan influir fácilmente. Los que carecen de convicción son los más vulnerables a la manipulación”.

Después de ello no se vieron más tuit de la herramienta, lo que hace suponer que “alguien estiró del enchufe”. O bien que al analizar la plataforma comprendió que el algoritmo actual de Twitter impide que llegue a las masas sin suscribirse a Twitter Blue, optando por otra red social.

El programa que llamó a la reflexión

A pesar de que el código de ChaosGPT no está disponible en internet, por lo que no sabe si es un programa real, el programa en que dice basarse que es Auto-GPT sí existe y funciona, proporcionando una ‘prueba del concepto’, de un escenario posible.

Plantea la peligrosidad de las herramientas de inteligencia artificial, que no desaparece al descentralizarla en un Open Source.

La comunidad fundada por Eliezer Yudkowsky, Lesswrong, sostiene que la IA nos terminará matando a todos. Uno de los participantes de la comunidad afirma sobre ChaosGPT:

“Tras la nueva versión de Auto-GPT, me sorprendió ver lo rápido que algunas personas se volcaron en su uso con fines malignos, aparentemente solo por diversión. ¿Es esta la primera prueba empírica clara del argumento en contra de la disponibilidad como código abierto de estas tecnologías de propósito general?

No se necesitan 100 personas malvadas con acceso a una AGI de código abierto para destruir el mundo, basta con que un ‘colega’ en su habitación introduzca el prompt equivocado solo por las risas”